일리노이대-컬럼비아대 공동 연구팀 개발

美일리노이대 어바나-샴페인 연구팀은 컬럼비아대, 텍사스대 오스틴과 공동으로 로봇이 비싼 센서나 원격 조작 없이도 동영상을 통해 복잡한 도구 사용법을 익힐 수 있는 새로운 학습 프레임워크를 개발했다고 밝혔다.

이번 연구 성과는 아카이브(arXiv)에 공개돼 있으며, ‘인터페이스로서의 도구(Tools as Interfaces)’라는 이름이 붙었다. (논문 제목:Tool-as-Interface: Learning Robot Policies from Human Tool Usage through Imitation Learning)

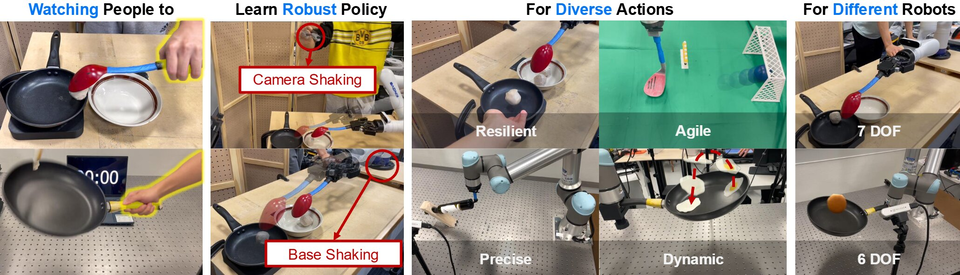

연구팀은 두 대의 카메라로 촬영한 영상을 기반으로 비전 모델(MASt3R)을 활용해 장면의 3차원 구조를 재구성하고, ‘3D 가우시안 스플랫’ 방식으로 다각도 시점을 생성했다. 이어 ‘Grounded-SAM’을 이용해 사람을 영상에서 제거하고 도구와 환경 간 상호작용만 분리, 로봇이 사람의 손동작 대신 도구 궤적과 방향에 집중하도록 설계했다. 이를 통해 서로 다른 형태의 로봇 간 기술 이전도 가능해졌다.

실험에서는 못 박기, 미트볼 뜨기, 팬에서 음식 뒤집기, 와인병 균형 잡기, 축구공 차 넣기 등 다섯 가지 과제를 수행했다. 모두 속도와 정밀성이 요구되는 고난도 동작으로, 기존 원격 조작 대비 성공률이 71% 높고, 데이터 수집 속도는 77% 빠른 결과를 보였다. 연구팀은 킹 슬롯이 미트볼을 뜨거나 달걀을 팬에서 뒤집는 등 기존에 난제로 꼽히던 동작에서도 안정적인 수행 능력을 입증했다고 설명했다.

연구팀은 “아이들이 어른을 보며 같은 도구가 아니라 비슷한 도구로 연습하듯, 로봇도 같은 방식으로 배울 수 있음을 확인했다”고 말했다. 이어 “전문 운영자나 고가 하드웨어 없이도 로봇이 사람들의 영상을 보고 손쉽게 배울 수 있는 길을 열었다”며 “유튜브 영상이나 스마트폰 촬영 자료가 로봇 학습 자원이 될 수 있다”고 강조했다.

다만 연구팀은 “로봇 그리퍼에 도구가 단단히 고정돼 있다는 가정” 등 아직 한계가 존재한다고 인정했다. 향후 다양한 도구 형태에 적용 가능한 인식 시스템 고도화가 필요하다는 설명이다. 연구진은 “카메라 영상과 적절한 알고리즘만으로도 로봇의 학습 패러다임이 근본적으로 변화할 것”이라며 “보다 적응력 있고 유용한 차세대 로봇 개발의 기반이 될 것”이라고 말했다.

ksjang@irobotnews.com